1. Big-Data-Blowout

Haben Sie sich bei der Lektüre ihrer IT-News gefragt, warum mit beständiger Regelmäßigkeit Facebook unangenehm auffällt? Warum eine effektive Regulierung des Big Data-Konzerns bisher schwer fiel – trotz der zahlreichen Skandale (siehe z. B. Frances Haugens Aussagen)?

Oft wird die Komplexität der Technik des IT-Sektors als Begründung angeführt. Komplexe Branchen (die bereits reguliert sind) gibt es allerdings auch in anderen Bereichen (z. B. Gesundheitswesen).

Meist stößt man noch auf den Umstand, dass Big Data ein relativ neues Konzept ist. Dies besteht meist aus einer kostenfreien Dienstleistung (Plattform) und diversen Sensoren zur Datenerfassung (Algorithmen auf der Facebook-Plattform, aber auch z. B. Facebook-Pixel, Social-Media-Buttons, Facebook-Login usw.). Die Rohstoffgrundlagen sind einerseits Aufmerksamkeit sowie Interaktion (Engagement) und andererseits persönliche Daten (hierzu zählen auch aus dem Verhalten abgeleitete Daten). Beide Elemente interagieren auf der Plattform miteinander, ähnlich einer Reaktionsmasse. Je länger die Verweildauer und je intensiver die Interaktion auf der Plattform, desto mehr und genauere Daten entstehen in schnelleren Intervallen. Interaktion entsteht wiederum aus dem Miteinander von Menschen auf der Plattform – deswegen Social Media – und auch durch das Verbreiten von Inhalten auf der Plattform. Umso genauer das Datenprofil wird, desto exakter lässt sich Aufmerksamkeit und Interaktion erzeugen, indem Inhalte auf die abgeleiteten Interessen abgestimmt werden – dies wird Personalisierung und Relevanz genannt.

Die Rohstoffe werden durch Facebook zu Werbeprodukten geformt – daher ist der viel zitierte Satz: »Wenn Du mit deinen Daten bezahlst, wirst Du zum Produkt« nicht richtig. Denn er suggeriert eine gewisse Relevanz in der Wertschöpfung, die keiner bloßen Rohstoffquelle innewohnt. Denn entscheidend für eine Rohstoffquelle ist nur deren ausreichende Verfügbarkeit.

Der Knackpunkt dieser Wertschöpfungskette muss unweigerlich eine breite Basis aus Nutzer*innen sein – deswegen gibt es bei Facebook nur zwei Imperative: Wachstum und Engagement. Nur wenn genug Menschen die Plattform (dauerhaft) nutzen, kann ein Netzwerkeffekt entstehen. D. h. erst durch den Umstand, dass man viele bekannte Menschen bei Facebook finden kann, wird es als Netzwerk überhaupt nützlich.

Facebooks Technik und Geschäftsmodell zu erklären mag noch gelingen. Der eigentliche Kern des Dilemmas ist: Wie macht man die Auswirkungen auf unser Leben, unsere Demokratie nachvollziehbar? Daten sind nun mal nicht stofflich – Facebooks Überwachungs-Werbeprodukte sind es daher ebenso wenig.

Behelfen wir uns zunächst mit einer rhetorisch naheliegenden Verständnisbrücke. Die des viel zitierten Rohstoffvergleiches: Daten wären das neue Öl. Natürlich existieren Unterschiede, allerdings soll ein Vergleich eben auch diese Unterschiede zu Tage fördern.

In diesem Beitrag konzentrieren wir uns zunächst darauf, Gründe und Ursachen eines unerwünschten Ereignisses (Blowout) zu finden sowie durchbrochene (oder nicht vorhandene bzw. wirkungslose) Sicherheitsbarrieren zu erkennen – dies beispielhaft anhand der Abfolge von Ereignissen und Umständen des Cambridge-Analytica-Skandals. In Teil 2 werden wir dann Auswirkungen einer »digitalen Informations-Ölpest« beleuchten.

Der folgende Beitrag ist nicht frei von Meinungsäußerungen des Autors.

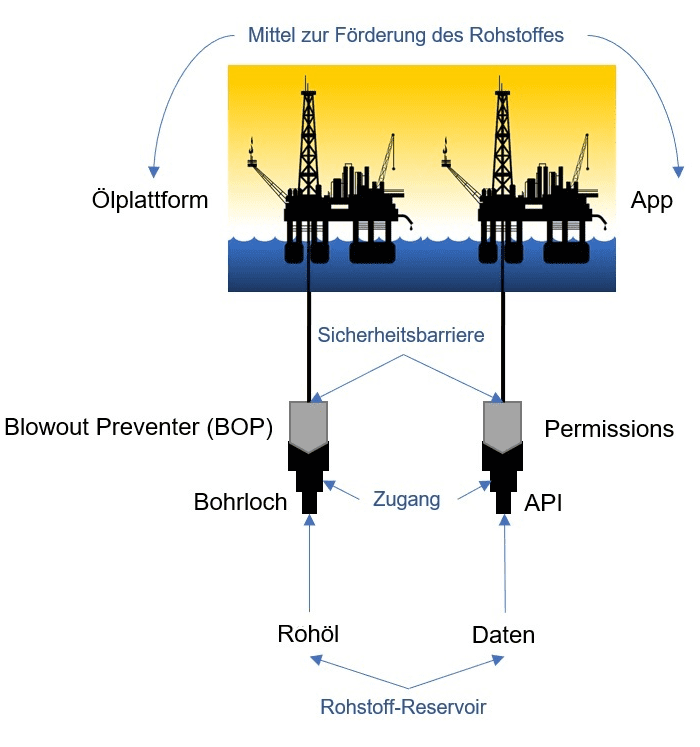

Quelle: Durch den Autor erstellt. Clipart von Opencliparts.org / License: CC0 1.0 Universal.

Anmerkung: Der Blowout Preventer ist eine massive, turmhohe Stahlkonstruktion aus Ventilen, die wie ein »Stöpsel« funktioniert und das Bohrloch verschließt. Er kann geöffnet und geschlossen werden und stellt eine physische Sicherheitsbarriere dar.

Für Facebooks Datenzugriff stellen Zugriffsberechtigungen (Permissions) eine Sicherheitsbarriere dar. Eine anschauliche Erklärung (Graph v1) findet sich beispielsweise hier: Na Wang Et. Al. (2011). Third-party apps on Facebook: Privacy and the illusion of control. https://doi.org/10.1145/2076444.2076448.

Auf einige Unterschiede sei eingangs schon hingewiesen: i) Daten können z. B. beliebig oft vervielfältigt werden und sind theoretisch unbegrenzt verfügbar – sie entstehen auch immer wieder neu. ii) Unterliegt die Vergabe zur Ausbeutung eines Ölfeldes einer staatlichen Ermächtigung. Im Unterschied dazu ermächtigt sich Facebook über die Nutzungsbedingungen selbst, diesen Datenschatz auszubeuten.

Companies like Facebook should not be allowed to behave like »digital gangsters« in the online world, considering themselves to be ahead of and beyond the law.

Quelle: House of Commons Digital, Culture, Media and Sport Committee. (2019, Februar). Disinformation and »fake news«: Final Report (Nr. HC 1791). House of Commons, S. 42.

Gastbeitrag von lacrosse

Lacrosse ist betrieblicher Datenschutzbeauftragter in der Konzerndatenschutzorganisation einer deutschen Unternehmensgruppe. In seiner Freizeit engagiert er sich ehrenamtlich, um gemeinnützigen Vereinen bei der Umsetzung der DSGVO zu helfen.

Feedback und Fragen können direkt an ihn gerichtet werden. Spenden für seine Arbeit möchte er direkt dem Kuketz-Blog zukommen lassen. Ihr könnt also direkt an den Kuketz-Blog spenden.

2. Elefanten & das neue Öl

Ergiebige Ölfelder werden in der Energiebranche als Elefanten bezeichnet. Auf der Jagd nach diesen Elefanten trieben Unternehmen wie BP Bohrungen in immer extremeren Meerestiefen voran. Mississippi Canyon Block 252 ist ein 9 Quadrat-Meilen großes Gebiet im Golf von Mexico – den Namen des Ölfeldes: Macondo, das circa 66 Kilometer vor der Südostküste Louisianas liegt, werden nicht viele Mensch kennen. Wir kommen noch darauf zurück.

Overconfident professionals sincerely believe they have expertise, act as experts and look like experts. You will have to struggle to remind yourself that they may be in the grip of an illusion.

Quelle: Contributors to Wikimedia projects. (2021, 31. Oktober). Overconfidence effect. Wikipedia.

Als erster Ausgangspunkt für einen Vergleich seien zunächst zwei Aussagen verschiedener Unternehmenslenker gegenübergestellt, deren gemeinsame Deutung eine überzogene Zuversicht in die Fähigkeiten der von ihnen geleiteten Organisationen ist.

[…] Zuckerbergs Keynote endet mit den Worten: Die Zukunft liegt jenseits dessen, was wir uns vorstellen können. […]

Quelle: Bager. (2021). »Profit um jeden Preis«: Interna zeichnen ein verheerendes Bild der Facebook-Führung. c’t, 24, S. 14.

[…] the Gulf of Mexico, which is a proving to be a showcase for BP’s deepwater skills and technology.

Quelle: BP & Chairman Sutherland. (2009). BP Annual Review 2008: 100 years of operating at the frontiers, S. 3.

Umso verblüffender ist es, dass weder die Zuversicht in Facebook noch damals in BP objektiv zu rechtfertigen sind / waren – denn nach einem Muster auftretende, wiederkehrende Vorkommnisse deuten auf strukturelle Probleme in einer Organisation hin. Als Beispiele (unter vielen) seien das bisher höchste von der FTC verhängte Bußgeld (Facebook) und die Explosion der BP-Raffinerie in Texas City genannt.

Entgegen einer keineswegs makellosen Incident-Bilanz scheint man dennoch überzeugt, jede noch so komplexe Herausforderung meistern zu können – diese sind allerdings unweigerlich den Zwängen von Budget und Deadline unterworfen. Dennoch begibt man sich selbstüberschätzend auf Elefantenjagd.

[…] Our mission is to make the world more open and connected […]

Quelle: House of Commons Digital, Culture, Media and Sport Committee & ehem. VP Product Management Facebook Lessin. (2018). Note by Damian Collins MP, Chair of the DCMS Committee: Summary of key issues from the Six4Three files (Exhibt 38 / FB-01389033).

Dabei ist das eigentliche Vorhaben zwar interessant, bedeutender ist aber der gemeinsame Nenner aus komplexen und spektakulären Umständen – die Ursachen für ein Scheitern sind dann ebenso vielschichtig, wie die Auswirkungen gravierend sind. Ob es sich bei diesen Unterfangen um eine Tiefseebohrung in einer Wassertiefe von eineinhalb Kilometern (plus vier Kilometer Meeresboden) oder um das Data-Mining bei mehreren Milliarden Menschen handelt, der gemeinsame Nenner macht beide Unternehmungen vergleichbar.

Das Macondo-Ölfeld mag kaum in Erinnerung sein. Der Inbegriff des tragischen Scheiterns ist es dennoch. Die Tragödie am 20. April 2010 ist allerings mit dem Namen einer dynamisch positionierbaren Halbtaucher-Explorationsbohrplattform verbunden. Dem der Deepwater Horizon. Ironischerweise tragen die neuen Metaverse-Produkte (Home, Work usw.) des neuerdings umetikettierten Facebook-Konzerns (Meta) ebenfalls den Begriff »Horizon«.

3. Zusammenspiel tausender beweglicher Teile

Das magentafarbene Alarmsignal auf der Brücke der Deepwater Horizon (DWH) warnte am 20. April vor einem gefährlichen Anstieg entflammbaren Methangases. Kurz danach saugte die Belüftung einer der Diesel-Generatoren der Plattform das Gas an – der Generator überdrehte und es kam zur ersten verheerenden Explosion. Aber nicht dieses eine Ereignis hat die Katastrophe verursacht. Genauso wenig wie Dr. Aleksandr Kogans »thisisyourdigitallive«-App den Cambrigde-Analytica-/ Facebook-Skandal verursacht hatte – handelte es sich dabei doch, ähnlich wie Generator Nummer 3, lediglich um eine Zündquelle.

[…] one individual did not cause the Macondo event. A multitude of decisions and actions up and down the organizational chains of both companies impacted the events […] and those decisions and actions are influenced by the invisible and often unstated basic assumptions and shared values of the involved companies.

Quelle: U.S. Chemical Safety and Hazard Investigation Board. (2010). Investigation Report Volume 3: Drilling Rig Explosion and Fire at the Macando Well (Nr. 2010–10-I-OS), S. 241.

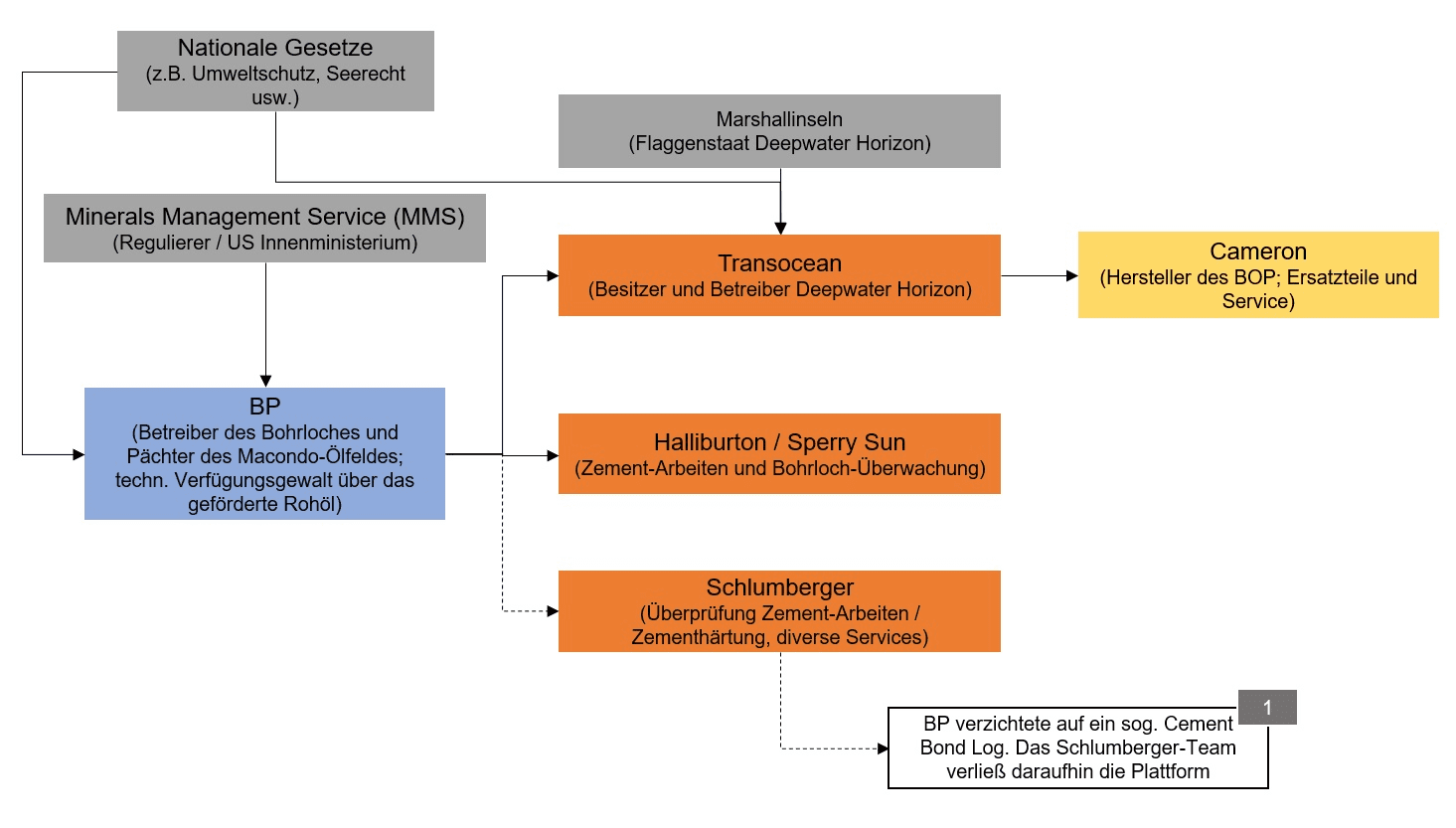

Beginnen wir aber am Anfang. Unser Wirtschaftssystem ist arbeitsteilig, d. h. Unternehmen lagern bestimmte Tätigkeiten an Vertragspartner aus. Nichts anderes galt für das Macondo-Ölfeld. Zwar war BP der Betreiber und Pächter (es ist also BPs Öl), das Unternehmen Transocean hatte aber die DWH an BP geleast. Hinzu kamen Spezialfirmen, die unterschiedliche Tätigkeiten ausführten, sowie der Hersteller des BOP (Sicherheitsbarriere). Diese Aufteilung bedeutet eine Gemengelage unterschiedlichster Organisationen – jedes Unternehmen hat sein eigenes Geschäftsmodell und -ziel und eine individuelle Struktur und Kultur. Dieses heterogene Konstrukt muss nun zielgerichtet kooperieren und kommunizieren – kein einfaches Unterfangen in einem komplexen Umfeld.

Quelle: Durch den Autor erstellt. Zu 1: National Commission on the BP Deepwater Horizon Oil Spill and Offshore Drilling. (2011). Deep Water: The Gulf Oil Disaster and the Future of Offshore Drilling. Report to the President.

Dieselbe Arbeitsteiligkeit lässt sich auch bei Facebook beobachten. Im Unterschied zu BP, das eine faktische Verfügungsgewalt über den Rohstoff hat, kann Facebook seine Verfügungsgewalt über den Rohstoff nur indirekt (rechtlich) ausüben.

It was really personal data, and they basically allowed that to leave Facebook’s servers intentionally, and then there were not any controls once the data had left […]

Quelle: House of Commons Digital, Culture, Media and Sport Committe. (2018, März). Oral Evidence: Fake News. Witness: Sandy Parakilas, former Facebook operations manager (Nr. HC 363). House of Commons, Q1206.

Sobald Daten über eine Schnittstelle (API) übermittelt wurden, sind sie vervielfältigt und einer direkten Kontrolle entzogen. Diese spezielle Form der fast symbiotischen Arbeitsteilung hat letztendlich das Ziel, mehr Engagement und mehr Daten für Facebook zu erzeugen. Denn über die App-Nutzung fließen auch Daten zurück – dieses Prinzip nennt Facebook »Data Reciprocity«.

[…] »Data reciprocity« is the exchange of data between Facebook and apps, and then allowing the apps’ users to share their data with Facebook. […]

[…] Facebook says instead, »Developers, please come and spend your engineering hours and time in exchange for access to user data«.[…]

Quelle: House of Commons Digital, Culture, Media and Sport Committee. (2019, Februar). Disinformation and »fake news«: Final Report (Nr. HC 1791). House of Commons, S. 33.

Wohlgemerkt stellen die Datenübermittlungen – aus Facebooks Sichtweise – nicht notwendigerweise ein Problem dar. Die APIs wurden zu diesem Zweck geschaffen. Genau diese Sichtweise vertrat der ehemalige CSO von Facebook Alex Stamos in einem Tweet:

As Stamos tweeted out Saturday (before later deleting the tweet): […]

[…] The ability to get friend data via API, with the permission of the user, was documented in our terms of service, platform documentation, the privacy settings, and the screen used to login to apps.

Quelle: Wagner. (2018). Here’s how Facebook allowed Cambridge Analytica to get data for 50 million users. vox.com.

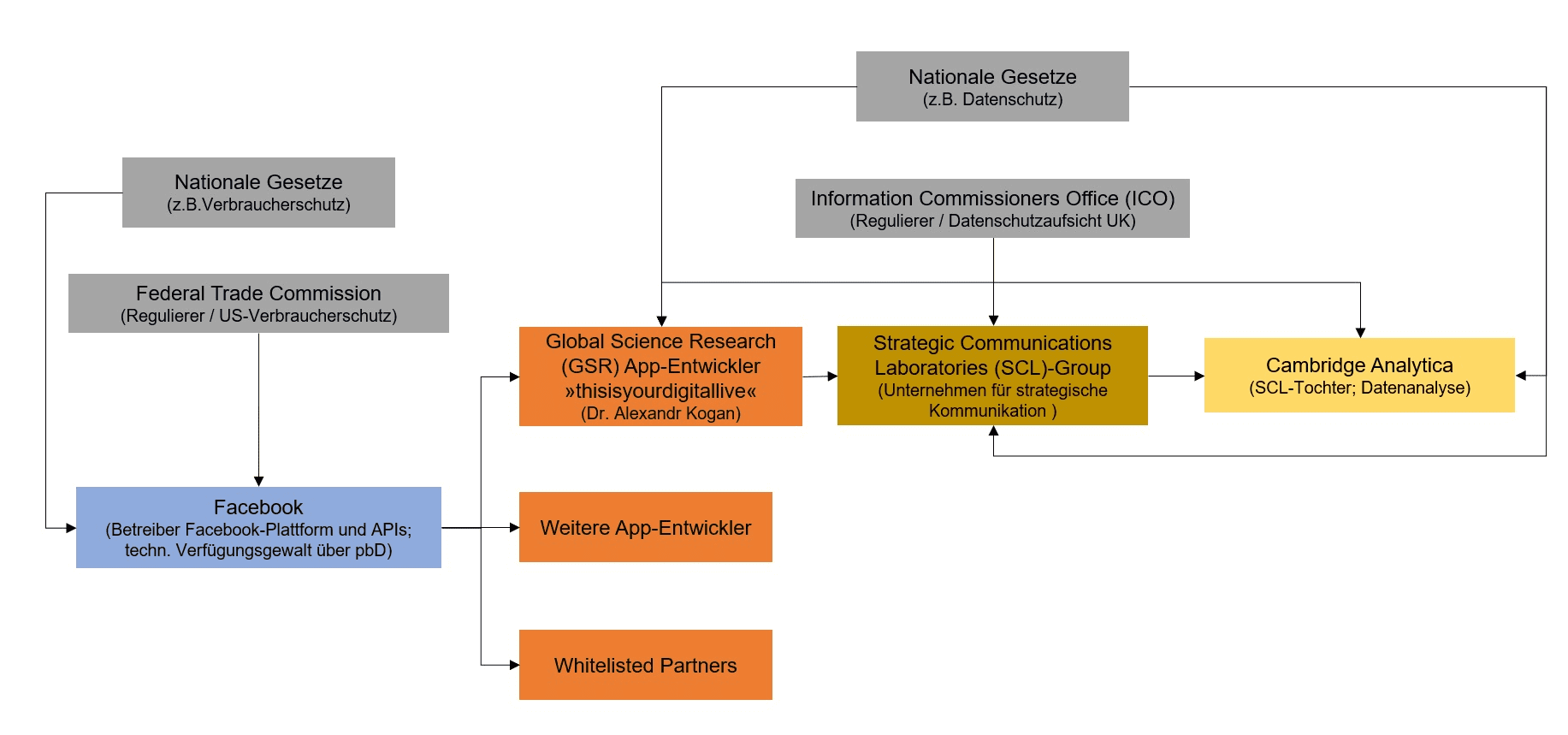

Die Untersuchungen des britischen Parlaments, des US-Senats und -Kongresses sowie diverser Aufsichtsbehörden (FTC, ICO usw.) zu Cambrigde Analytica (CA) ermöglichten aber zum ersten Mal Einblicke in die Arbeitsteiligkeit sowie Entscheidungsabläufe von Facebook (FB). D. h. wer zu welchen Bedingungen Datenzugänge erhielt sowie welche Sicherheitsbarrieren existierten und wie wirksam diese waren, konnte erstmals eingeschätzt werden.

Daten sind Informationen in digitaler Form. Dadurch sind ihre Verwendungszwecke und Endprodukte auch extrem form- und wandelbar. Man muss nur über die Daten und die Technik verfügen. Daher kann es jederzeit zu schädlichen Zweckänderungen kommen – wie im Falle von CA. Die Auswirkungen erleben wir meist in Form einer »digitalen Informations-Ölpest«. Sei es durch das Offenlegen persönlicher Daten oder Desinformations-Kampagnen, die z. B. mittels Mikrotargeting ausgesteuert werden.

Quelle des Diagramms: Information Commissioner Office (ICO). (2018, Juni). Investigation into the use of data analytics in political campaigns: Investigation update.

Die Schwierigkeit (für Regulatoren) und gleichzeitig die Gemeinsamkeit beider arbeitsteiliger Konstrukte ist allerdings offensichtlich: Wer ist verantwortlich, wenn etwas schief geht? Wird die Frage der Verantwortlichkeit (Accountability) gestellt, fallen oft Begriffe wie »Unfall«, »Unglück« oder »Bad Actor«. Manchmal entsteht auch der Eindruck, eine Art Naturgewalt wäre verantwortlich.

Daher müssen die entscheidenden Fragen von außen (z. B. Zivilgesellschaft, Parlament usw.) gestellt werden: Sind Unternehmensstruktur, -organisation und -kultur auf ein riskantes, intransparentes Geschäftsmodell ausgerichtet? Operiert man in einem komplexen System, das im Falle eines Incident einen möglichen gesellschaftlichen Kollateralschaden (Umwelt, Demokratie, wirtschaftliche Stabilität usw.) nach sich zieht?

Intransparente Arbeitsteiligkeit kann dabei ein Risikoindiz darstellen – insbesondere bei digitalen Informationen.

4. Hoffnung ist keine Taktik

I think you all trying to run out of fuel as the wheels touch down. Running out of gasoline as the plane lands is not smart. It’s flawed thinking. It’s hope as a tactic.[…]

Quelle: Mark Wahlberg als Mike Williams im Film Deepwater Horizon / Video des Dialogs auf Youtube

Diese Sätze lässt der Drehbuchautor Mark Wahlberg in der Verfilmung von Deepwater Horizon zum BP-Vertreter auf der Plattform sagen. Gemeint ist die Tendenz, Effizienzoptimierung und Wachstumsgeschwindigkeit so weit zu treiben, bis es keinen Sicherheitsspielraum mehr gibt und dann auf das Beste zu hoffen. »Es ist noch immer gut gegangen« als Management-Prinzip. Eine andere, radikalere Spielart davon ist Facebooks »Move fast and break things«.

Ähnliche Dialoge, wie die mit Mark Wahlberg, durchziehen den Film wie ein roter Faden. Das kann man als dramaturgischen Kniff abtun. Sofern man sich mit Risikomanagement beschäftigt, ist dieser Denkfehler ein vertrautes Phänomen – seine tieferliegende Ursache sind u. a. die Bemessungsgrundlagen von Anreizsystemen. D. h. wofür ein Manager in einer Organisation Boni (oder Anerkennung) erhält.

[…] you guys like my granddad […] He never even went to the dentist, because he didn’t want to know what all was wrong. Because then they had to deal with it.[…]

Quelle: Kurt Russel als James Harrell im Film Deepwater Horizon / Video des Dialogs auf Youtube

Der Film-Charakter Mr. Jimmy bringt die Auswirkungen dieses Denkfehlers, die als Ignoranz, Desinteresse und mangelnde Voraussicht in Erscheinung treten, auf den Punkt. Dies mag fiktiv sein, es finden sich allerdings Parallelen zu Facebooks Verhalten bei einer Zweckänderung der Datenverwendung durch Dritte.

[…], but the impression that I got was that if Facebook did an investigation and received information that showed that policies were being broken and potentially laws were being broken, then Facebook was liable. However, if Facebook did not know what was happening, they could claim that they did not know, […]

Quelle: House of Commons Digital, Culture, Media and Sport Committe. (2018, März). Oral Evidence: Fake News. Witness: Sandy Parakilas, former Facebook operations manager (HC 363). House of Commons, Q1228.

Die Bohrung im Macondo-Ölfeld bestand aus mehreren Phasen mit der immer gleichen Abfolge: Bohrung, Einsatz eines Röhrengehäuses und anschließende Zementierung zur Versiegelung. Bei den Zementarbeiten spielen sogenannte Zentrierer eine wichtige Rolle – sie sitzen an der Außenseite der Röhre und sollen unzementierte Hohlräume verhindern. BP nutzte weniger Zentrierer (als gesetzlich vorgeschrieben), da vor Ort nicht genug zur Verfügung standen – Verzögerungen waren allerdings mit hohen Zusatzkosten verbunden. Man nahm damit bewusst ein höheres Risiko in Kauf – ohne eine Risikoanalyse durchzuführen.

BP’s overall approach to the centralizer decision is perhaps best summed up in an e-mail from BP engineer Brett Cocales sent to Brian Morel […] concluded the e-mail by saying

But, who cares, it’s done, end of story, [we] will probably be fine and we’ll get a good cement job. I would rather have to squeeze [remediate the cement job] than get stuck above the WH [wellhead]. So Guide is right on the risk/reward equation.

Quelle: National Commission on the BP Deepwater Horizon Oil Spill and Offshore Drilling. (2011). Deep Water: The Gulf Oil Disaster and the Future of Offshore Drilling. Report to the President, S. 116.

Aus diesen Denkfehlern können zwar riskante Verhaltensmuster (wie oben) entstehen, diese müssen allerdings nicht immer unmittelbar negative Folgen haben. Ggf. ist das genaue Gegenteil der Fall. Der menschliche Lernprozess ist aber darauf ausgerichtet, aus unmittelbaren Ergebnissen zu lernen.

[…] Facebook argued that given the volume of apps on its platform, it would be »too costly« to review privacy policies of third-party apps, or to ensure that those apps adequately described how users’ information obtained from Facebook will be used or further disclosed.

Quelle: Office of the Privacy Commissioner of Canada. (2019). Joint investigation of Facebook, Inc. by the Privacy Commissioner of Canada and the Information and Privacy Commissioner for British Columbia (Nr. 2019–002), RN 63. (Hervorhebung durch den Autor)

Oder anders formuliert: Bleibt ein negatives Ereignis (zunächst) aus, können die Entscheidungen nicht falsch gewesen sein. Sind die Kennzahlen (dazu können auch Kosteneinsparungen gehören), als vermeintlich objektiver Maßstab, vielversprechend, muss das System als solches auch gut sein – siehe auch Facebooks Wachstumsraten bei den App-Werbeeinnahmen. Diese Kennzahlen können allerdings einen blinden Fleck erzeugen: Nämlich den, durch welche Methoden die Kennzahl erreicht wurde.

The nekko [sic.] growth is just freaking awesome. Completely exceeding my expectations re what is possible re ramping up paid products.

Quelle: House of Commons Digital, Culture, Media and Sport Committee. (2019, Februar). Disinformation and »fake news«: Final Report (Nr. HC 1791). House of Commons, S. 33.

»Neko« was Facebook’s internal name for its new mobile advertising product, Mobile App Install Ads.

Quelle: House of Commons Digital, Culture, Media and Sport Committee. (2019, Februar). Disinformation and »fake news«: Final Report (Nr. HC 1791). House of Commons, S. 29.

Die Herausforderung, richtige Entscheidungen abhängig von der jeweiligen Situationen zu treffen, ist uns aus dem Alltag bekannt. Denken wir an Auto- oder Radfahren bei unterschiedlichen Wetterlagen oder der Besuch im Schwimmbad mit einem Kleinkind. Dies nennt man Situationsbewusstsein. Grob umrissen, ist es die Fähigkeit, eine Sachlage richtig einzuschätzen, daraus korrekte Schlussfolgerungen zu ziehen und dann angemessene Entscheidungen zu tätigen. Dies ist aber hochgradig von der Umgebung, der geistigen Haltung und den verfügbaren Informationen abhängig. Allerdings kann eine Situation, in der Informationen (positiv) umgedeutet werden, damit sie zu einer gefühlten Sachlage passen, gefährlich werden.

5. Ein »Kick« als Vorwarnung

Die DWH bohrte unter schwierigsten Bedingungen. Die im Meeresboden eingeschlossenen Rohöl- und Gasvorkommen standen unter enormem Druck und waren durch die Gesteinsmassen und die Wassersäule darüber stark verdichtet. Daher waren die Sicherheitsbarrieren zwischen diesen Vorkommen (darunter auch entflammbare Gase) und der Oberfläche entscheidend. Dem Situationsbewusstsein der Crew kommt unter diesen Bedingungen sicherlich eine besondere Bedeutung zu. In 1500 Metern Tiefe kann man das Ergebnis der Arbeiten nicht in Augenschein nehmen. Man muss dies indirekt, mittels einer stetigen Überwachung eines Datenstromes, beurteilen – eine weitere Parallele zu FB.

Many aspects of an organization’s culture are unstated, underlying, and often operate at a subconscious level. As such, efforts to assess and change culture are challenging. Frequently depicted visually as an iceberg, only a small portion of culture is actually observable.

Quelle: U.S. Chemical Safety and Hazard Investigation Board. (2010). Investigation Report Volume 3: Drilling Rig Explosion and Fire at the Macando Well (Nr. 2010–10-I-OS), S. 234.

Allerdings darf eine Lagebeurteilung sowie Entscheidungsgrundlagen nicht ausschließlich auf operativen Schultern lasten. Dies zeigt sich in der situativen Wahrnehmung aller an Bord der DWH: Man wähnte sich vor dem Abschluss der Arbeiten und war kurz davor, das Bohrloch vorübergehend aufzugeben (»temporary abandonment«). In dieser Geisteshaltung interpretierte man die Ergebnisse eines Drucktestes falsch und übersah in einem kritischen (und kurzen) Zeitraum starke Druckveränderungen.

Der entscheidende Faktor sind daher Vorgaben des Managements, die klare Leitlinien setzen. Gerade bei ungewissen, aber potentiell alarmierenden Informationen muss es klare Verfahrensrichtlinien für »Red Flags« geben. Der Verantwortungsdruck, insbesondere für Zusatzkosten bzw. Verzögerungen, muss von der Managementebene getragen werden.

The most significant failure at Macondo—and the clear root cause of the blowout—was a failure of industry management.

Quelle: National Commission on the BP Deepwater Horizon Oil Spill and Offshore Drilling. (2011). Deep Water: The Gulf Oil Disaster and the Future of Offshore Drilling. Report to the President, S. 122.

Daher muss Sicherheit (Datenschutz, IT-Sicherheit, Arbeitssicherheit usw.) ein fester Bestandteil der Unternehmenskultur und Arbeitsabläufe sein – ein Beiseiteschieben für kurzfristige Erträge oder vermeintliche Kostenersparnisse erweist sich langfristig oft als gefährliches Risiko. Allerdings liegt es manchmal in der Natur von gesellschaftlichen Kollateralschäden, dass der Verursacher nicht unbedingt der Leidtragende ist.

[…] The company’s leadership knows ways to make Facebook and Instagram safer and won’t make the necessary changes because they have put their immense profits before people. […]

I saw that Facebook repeatedly encountered conflicts between its own profits and our safety. Facebook consistently resolved those conflicts in favor of its own profits. […]

Quelle: United States Senate Committee on Commerce, Science and Transportation Sub-Committee on Consumer Protection, Product Safety, and Data Security. (2021, Oktober). Statement of Frances Haugen.

In hierarchischen Organisationen werden Leitlinien von oben nach unten vorgegeben und damit Schwerpunkte in den Arbeitsabläufen gesetzt. Denn Schwerpunkte des Managements erzeugen Druck, der von oben nach unten verläuft. Man könnte auch sagen, der Fisch stinkt immer vom Kopf.

[…] and I am not sure that leadership is giving guidance to say, »No, you know what? This is a priority. User privacy is a priority, […]«

Quelle: House of Commons Digital, Culture, Media and Sport Committe. (2018, März). Oral Evidence: Fake News. Witness: Ashkan Soltani, tech expert (Nr. HC 363). House of Commons, Q4349, Video der Aussage (circa 1:49).

Priorisierungen in Organisationen kann man u. a. an Lern- und Adaptionsprozessen erkennen, d. h. dass auf Vorfälle ernsthafte, kontinuierliche Verbesserungen folgen – dabei ist es zunächst unerheblich, ob sie direkt negative Auswirkungen hatten.

Dringen bei Tiefseebohrungen Gase durch die Rohleitungen an die Oberfläche, dehnen sich diese, durch den Druckunterschied, rapide aus. Es entsteht ein sogenannter Kick oder Druckstoß, der die gesamte Bohrung destabilisieren kann. Wird der Kick nicht unter Kontrolle gebracht, droht ein Blowout. Damit ist er eine Art Vorwarnung auf ein (noch) unerwünschteres Ereignis. Er ist auch ein Anzeichen dafür, dass Sicherheitsbarrieren versagt haben könnten.

A kick is an indicator that the primary well barrier failed and secondary well control actions by the crew are needed.

Quelle: U.S. Chemical Safety and Hazard Investigation Board. (2010). Investigation Report Volume 3: Drilling Rig Explosion and Fire at the Macando Well (Nr. 2010–10-I-OS), S. 159.

Ein Kick bei Facebook kommt, wie beispielsweise im Falle von CA, meist in der Gestalt von Nachrichtenmeldungen daher.

[…] Aside from the automated detections, Facebook submits it relied on user reports and tips, stories in the media and on blogs, as well as leads from internal tips from Facebook employees.

Quelle: Office of the Privacy Commissioner of Canada. (2019). Joint investigation of Facebook, Inc. by the Privacy Commissioner of Canada and the Information and Privacy Commissioner for British Columbia (Nr. 2019–002), RN 126. (Hervorhebung durch den Autor)

Dieser Druckstoß hatte sich in einer Abfolge von Ereignissen und Fehlentscheidungen – ähnlich wie bei der DWH – allmählich aufgebaut. FB-Beschäftigte registrierten im September 2015 Warnzeichen für einen möglichen Datenmissbrauch durch CA. Auf der operativen Ebene war daher ein gewisses Maß an Situationsbewusstsein – im Gegensatz zum FB-Management – dafür vorhanden, dass Sicherheitsbarrieren versagt hatten oder ungeeignet waren.

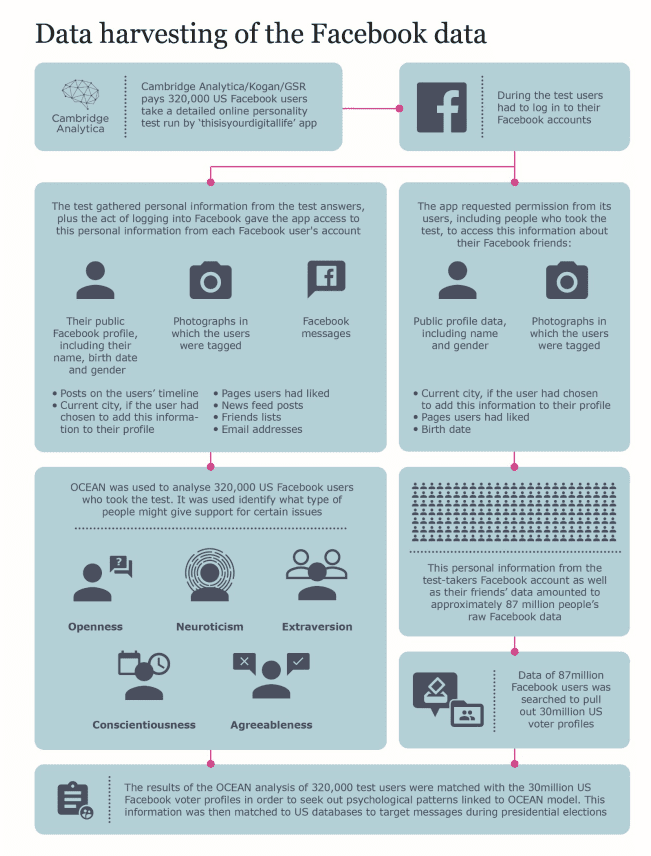

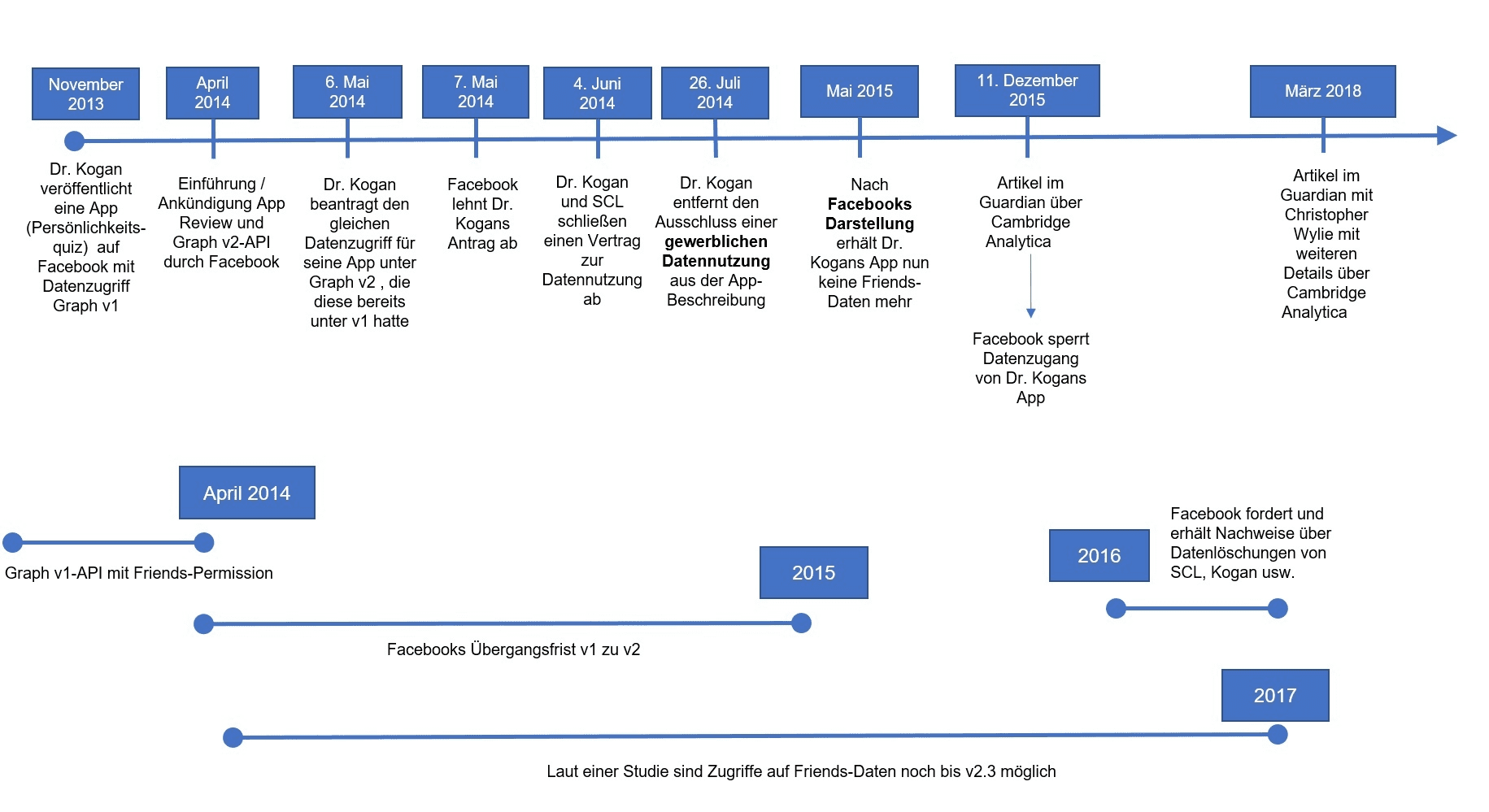

Untenstehende Zeitachsen zeigen die relevanten Ereignisse im Zusammenhang mit Dr. Kogans App.

Quelle Bild: Durch Autor anhand folgender Quellen erstellt: Symeonidis et al. (2018). Collateral damage of Facebook third-party applications: a comprehensive study. Office of the Privacy Commissioner of Canada. (2019). Joint investigation of Facebook, Inc. by the Privacy Commissioner of Canada and the Information and Privacy Commissioner for British Columbia (Nr. 2019–002). United States Federal Trade Commission (FTC). (2019). In Matter Cambridge Analytica, LLC, a corporation: Opinion of the Commission (Nr. 9383).

Wäre man diesen Warnhinweisen gefolgt, wäre dies vermutlich eine Gelegenheit für FB gewesen, den Schaden eines Daten-Blowouts zumindest ansatzweise abzumildern. Allein, es fehlte wohl am Handlungswillen des Managements.

Red Flags Raised About Cambridge Analytica’s Other Potential Misuse of User Data

At the time of the December 2015 Guardian article, Facebook was already familiar with Cambridge and had suspicions that Cambridge had misused user data. In September 2015, employees in Facebook’s political advertising group requested an investigation into possible »scraping« […], these employees reiterated their concern about scraping. […] and had described it as a “sketchy (to say the least) data modeling company […].”

Throughout 2016, red flags were raised to Facebook suggesting that Cambridge was potentially misusing Facebook user data. […], several Facebook employees became aware of media reports on Cambridge’s use of personality profiles to target advertising in the summer and fall of 2016. […] Despite Facebook’s suspicions about Cambridge and the red flags raised after the Guardian article, Facebook did not consider how this information should have informed the risk disclosures in its periodic filings about the possible misuse of user data.

Quelle: United States District Court of Columbia. (2019, Juli). Securities and Exchange Commission (SEC) , Plaintiff vs. Facebook Inc., Defendant: Complaint (Nr. 3:19-cv–04241).

Anmerkung: SEC=US-amerikanische Börsenaufsicht

Spätestens zu diesem Zeitpunkt wäre eine Risikoanalyse der gesamten Datennutzungspraxis angemessenen sowie eine Überprüfung der Datenzugriffe mit den Berechtigungen der API v1 dringend geboten gewesen.

Die Erkenntnis über den strukturell mangelhaften Datenschutz der FB-Plattform, insbesondere des Persmission-Systems, war FB jedoch bereits seit 2009 bekannt. Denn die kanadische Datenschutzaufsicht führte dazu aus:

In 2009, the OPC concluded an investigation into Facebook, examining […], disclosures to third-party applications on the Platform. […] OPC recommended that Facebook implement measures […]:

a. To limit application developers’ access to user information not required to run a specific application;

b. Whereby users would in each instance be informed of the specific information that an application requires and for what purpose;

c. Whereby users’ express consent to the developer’s access to the specific information would be sought in each instance; and

d. To prohibit all disclosures of personal information of users who are not themselves adding an application.

[…] Facebook declined to implement these measures. The final report concluded that Facebook: (i) failed to obtain meaningful consent from its users—including app users’ friends—to disclose their information; and (ii) had inadequate safeguards in place to monitor compliance by app developers with Facebook policies.

Quelle: Office of the Privacy Commissioner of Canada. (2019). Joint investigation of Facebook, Inc. by the Privacy Commissioner of Canada and the Information and Privacy Commissioner for British Columbia (Nr. 2019–002), RN 18-19.

6. Man hinkt mit strukturellen Sicherheitsproblemen voran

Multinationale Konzerne wie Facebook und BP umgibt oft die Marketing-Aura des ungemein fähigen Pioniers – in Innovation und Technik. Auch CA stellte sich als innovatives und fähiges Unternehmen dar.

[…] »Accidents are seldom preceded by bizarre behavior … Mishaps are the result of everyday influences on everyday decision making, not isolated cases of erratic individuals behaving unrepresentatively.«. Furthermore, human performance is often only deemed erroneous in the aftermath of a negative outcome. […] frequently finds a history of acceptable performance leading up to an incident that was never considered erroneous or critiqued until catastrophe happened.

Quelle: U.S. Chemical Safety and Hazard Investigation Board & Dekker. (2010). Investigation Report Volume 3: Drilling Rig Explosion and Fire at the Macando Well (Nr. 2010–10-I-OS), S. 22-23.

Strukturelle Sicherheitsprobleme mögen daher so gar nicht zu diesem Hochglanz-Image passen. So hatte FB Apps von privilegierten Partnern auf eine Whitelist gesetzt – mit der Folge, dass die Datenschutzeinstellungen von Nutzer*innen übersteuert wurden. Trotz dieses gefährlichen Eingriffes in die Sicherheitsbarriere »Permission« wurde dies überhastet und amateurhaft umgesetzt. Hier kam es offenbar zu einer Abwägung zwischen Zieltermin (mit der Kennzahl Werbeerlöse) und der handwerklich sauberen Implementierung einer Funktion.

[…] incredibly hacky and thrown together very haphazardly. […].

For example, in order to whitelist an app, all they did was say it was pre-installed for all users. That was the workaround, instead of creating a new oversight regime or a new API specifically for those apps. They essentially just added a flag to the database that said it is a pre-installed app, so it gets permissions by default, so it can skip over the consent process. That is very hacky. That is not very straightforward.

House of Commons Digital, Culture, Media and Sport Committe. (2018, März). Oral Evidence: Fake News. Witness: Ashkan Soltani, tech expert (Nr. HC 363). House of Commons, Q4349, Video der Aussage (circa 1:48).

Vergleichbare Defizite, wenn auch mit anderen Ausprägungen, gab es bei einer Software, die die Bohrkontrolle auf der DWH steuerte – hier kam es in regelmäßigen Abständen zum »Blue screen of death«. Selbstredend kann dies auf einer Bohrinsel eine gefährliche Situation sein, wenn man die Kontrolle über die Bohrung verliert.

[…] it controls everything, […] for three to four months, we have had problems with this computer simply locking up. We even coined a term »blue screen of death«. […] We had actually ordered […] new system […]. Those computers were actually used on a very unstable platform. Between the manufacture and the rig, they could not get the bugs worked out of the new operating system. They could not get the old software to run correctly on the new operating system. Our sister rig was going through those growing pains. […] We were just waiting for them to make it work. In the meantime, we were limping along with what we have. […]

Quelle: Michael (Mike) Williams. (2010, Juli). Deepwater Horizon Joint Investigation [Joint U.S. Coast Guard and Burea of Energy Management Hearing]. Investigation of Deepwater Horizon Explosion, Louisiana, Vereinigte Staaten, (circa 0:48).

Im Falle von CA kann man kaum mehr von IT-Sicherheit sprechen, denn es wurden grundsätzliche Regeln missachtet.

We found that individuals of interest to the investigation held data on various Gmail accounts. Data was also found in servers and appeared to have been shared with a range of parties, […]

Quelle: Information Commissioners Office (ICO). (2020, Oktober). RE: ICO investigation into use of personal information and political influence (ICO/O/ED/L/RTL/0181). Hervorhebung durch den Autor

Man kann bei den Feststellungen der ICO nur zu dem Schluss kommen, das CA über keinerlei nennenswerte Sicherheitskultur verfügte.

The servers seized under warrant revealed a chaotic IT infrastructure. CA failed to ensure that the information provided to it by Dr Kogan was transferred securely between themselves and external contractors.

Quelle des Diagramms: Information Commissioner Office (ICO). (2018, November). Investigation into the use of data analytics in political campaigns: A report to Parliament, S. 38. Hervorhebung durch den Autor

Hier endet auch jeder Vergleich zur BP und der DWH, dort mag das Management in wichtigen Teilbereichen fatal versagt haben. Bei CA kann man noch nicht einmal mehr von Versagen sprechen, sondern muss eine völlige Unfähigkeit beim Umgang mit Daten konstatieren – also dem Kern des eigenen Geschäftsmodells.

Dass Mangement-Vertreter strukturelle Sicherheitsprobleme ignorieren oder zumindest tolerieren, spricht Bände über die in diesen Unternehmen gesetzten Prioritäten. Wie wir gesehen haben, geschieht dies auch in anderen Industriesektoren – mit durchaus vergleichbaren Mustern.

Security breaches were identified when, as part of the execution of the warrant, Post-it notes were found on the walls of CA offices containing passwords. CA also failed to delete all the Facebook data in a timely manner, despite assurances given that it had done so.

Quelle des Diagramms: Information Commissioner Office (ICO). (2018, November). Investigation into the use of data analytics in political campaigns: A report to Parliament, S. 38. Hervorhebung durch den Autor

Aber: Ein System zu erdenken, in denen Daten derart leicht in die Verfügungsgewalt von Dilettanten geraten können, ist mehr als fahrlässig. Umso mehr, wenn dies Auswirkungen auf unsere Demokratie haben könnte.

7. Magenta-Alarm bei Facebook

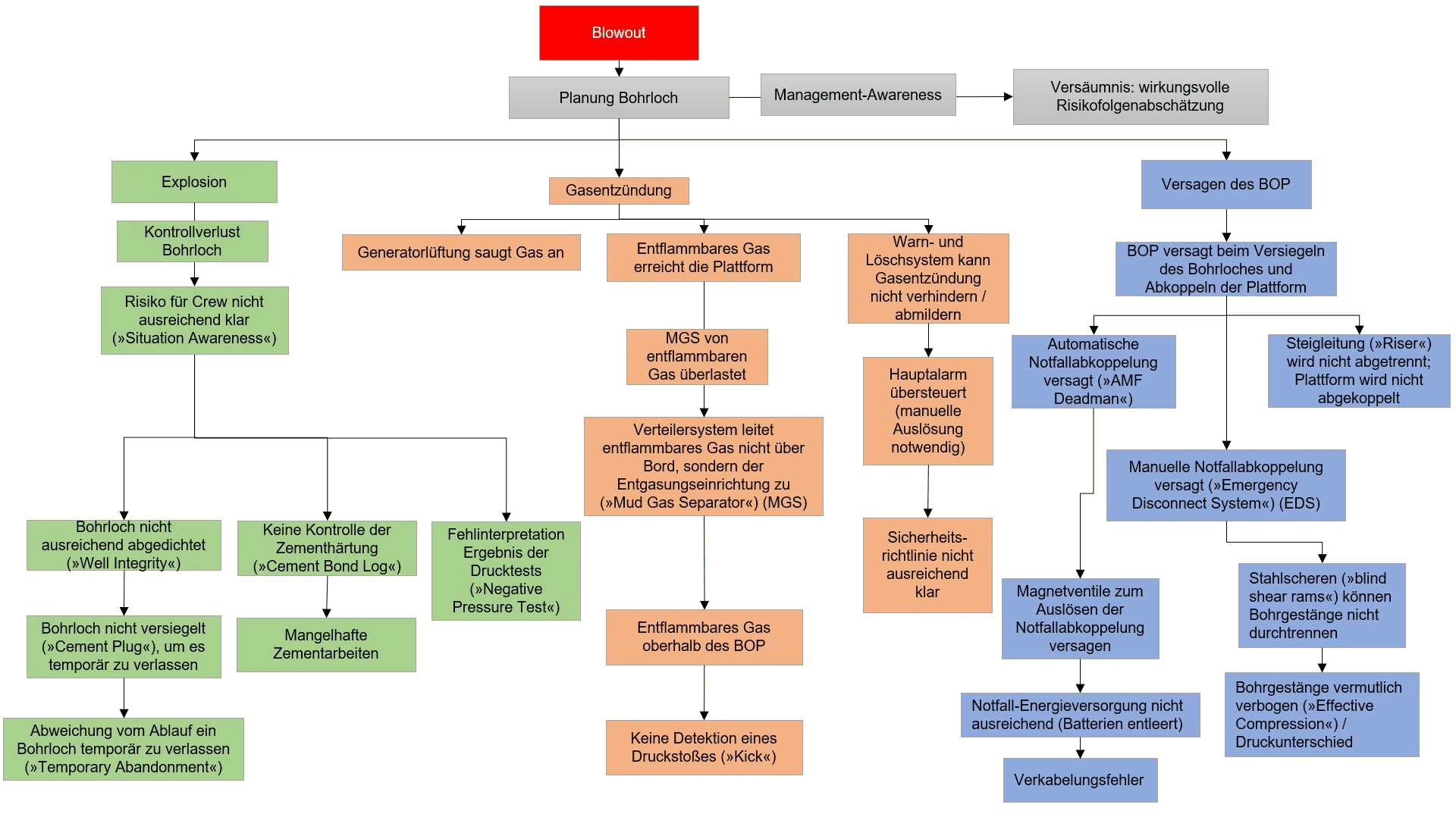

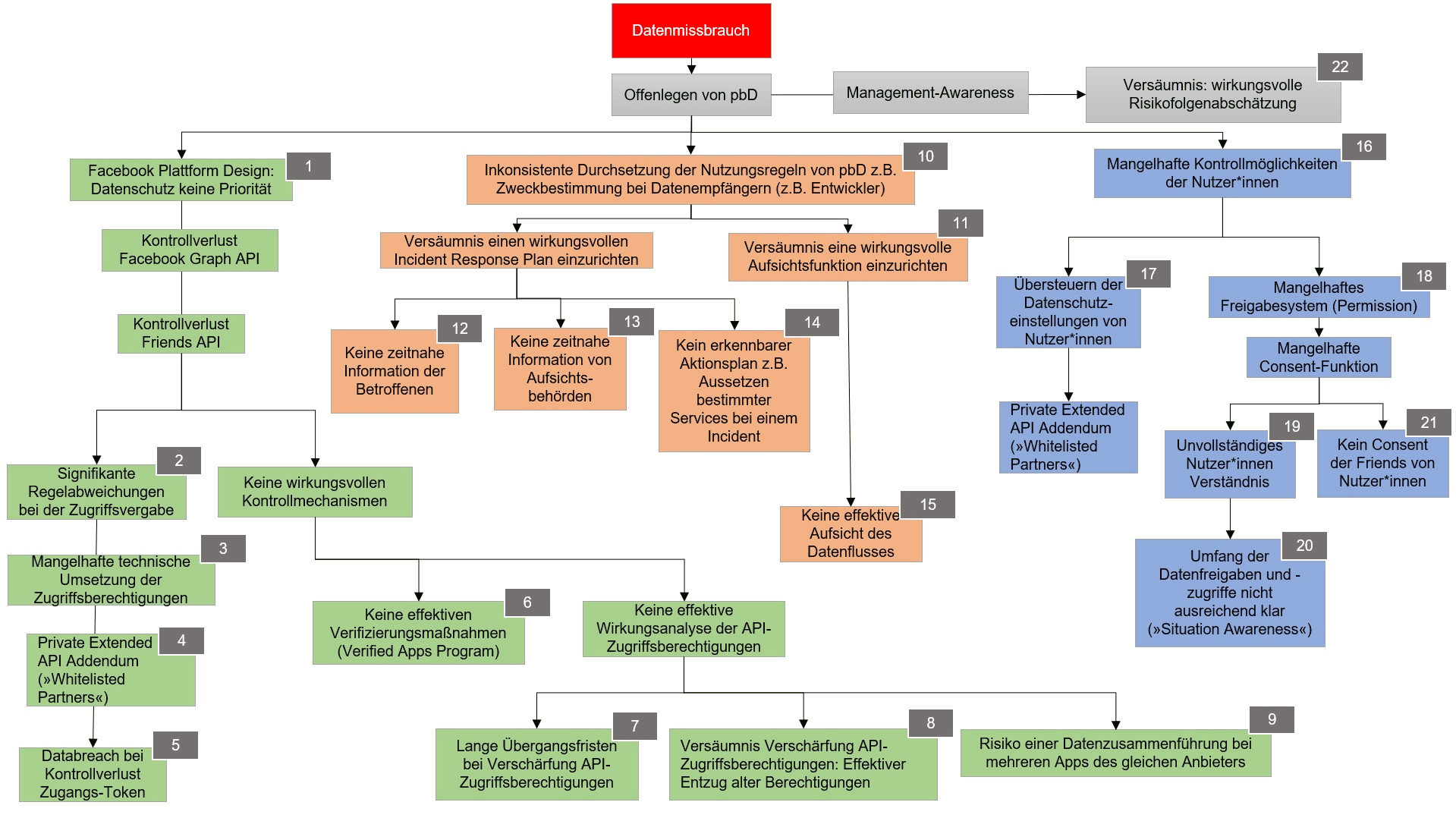

Wir haben aufgezeigt, dass Facebooks System keine arkane Technikmagie ist, sondern sich Parallelen zu anderen, techniklastigen Wirtschaftsbereichen finden lassen. Vergleicht man die beiden folgenden Diagramme, wird dies noch deutlicher. Beide Diagramme zeigen durchbrochene oder nicht vorhandene Sicherheitsbarrieren, die letztlich zu einem unerwünschten Ereignis führen.

Quelle Bild: Durch den Autor erstellt

Auf eine detaillierte Quellenangabe wurde verzichtet – im Gegensatz zum folgenden Facebook-Diagramm. Interessierte können die einzelnen Punkte in folgenden Quellen nachvollziehen: Quelle: National Commission on the BP Deepwater Horizon Oil Spill and Offshore Drilling. (2011). Deep Water: The Gulf Oil Disaster and the Future of Offshore Drilling. Report to the President. U.S. Chemical Safety and Hazard Investigation Board. (2010). Investigation Report Volume 1-4: Drilling Rig Explosion and Fire at the Macando Well (Nr. 2010–10-I-OS). Hierzu findet sich auch ein Video auf Youtube. Leser*innen würde ich besonders ans Herz legen, die Augenzeugenberichte auf C-Span anzusehen. Insbesondere die von Michael (Mike) K. Williams, Steven Ray Bretone, Jimmy (Mr. Jimmy) Harrell, Miles Randall (Randy) Ezell.

Quelle Bild: Durch den Autor erstellt

Darüber hinaus zeigt der Vergleich noch etwas anderes: Zwar wären beide Vorfälle vermeidbar gewesen. Aber, wie es in der Ursachenanalyse zur Deepwater-Horizon-Katastrophe so treffend heißt:

The root causes are systemic and, absent significant reform in both industry practices and government policies, might well recur.

Quelle: National Commission on the BP Deepwater Horizon Oil Spill and Offshore Drilling. (2011). Deep Water: The Gulf Oil Disaster and the Future of Offshore Drilling. Report to the President, S. 122.

Anhang für das Facebook-Diagramm

Der Anhang mit den Quellen findet sich in diesem PDF. Es ist zu beachten, dass sich ein Quellenverweis auf mehrere Punkte beziehen kann.Hintergrund für den Anhang: Der Vorsitzende des britischen Digital, Culture, Media and Sport Committee hatte den Geschäftsführer des App-Herstellers Six4Three bei einem Aufenthalt in London zur Herausgabe von Dokumenten gezwungen. Der App-Hersteller Six4Three hatte in einem kalifornischen Gerichtsverfahren gegen Facebook geklagt und gelangte in diesem Zusammenhang an interne Facebook-Informationen.

Unterstütze den Blog mit einem Dauerauftrag!

Unabhängig. Kritisch. Informativ. Praxisnah. Verständlich.

Die Arbeit von kuketz-blog.de wird vollständig durch Spenden unserer Leserschaft finanziert. Sei Teil unserer Community und unterstütze unsere Arbeit mit einer Spende.

8. Fazit

Der Beitrag zeigt auf, dass Big Data-Unternehmen als Industriesektor keineswegs beispiellos sind – auch wenn dies ein beliebtes Narrativ ist. Dabei geht allzu oft die Entwicklungsgeschwindigkeit zu Lasten des Sicherheitsspielraums. Sicherlich sind z. B. soziale Medien etwas Neuartiges. Allerdings sind die dahinterstehenden Geschäftsmodelle nur bedingt neu – Rohstoff und Rohstoffquellen mögen dabei neuartig sein. Die Mechanismen und Muster sind es keineswegs. Es wäre allerdings ein Fehler, Unternehmen wie Facebook oder BP (oder Transocean) als monolithischen Block zu sehen – also Belegschaft und Management über einen Kamm zu scheren. Dies kann man gerade am Beispiel der Deepwater Horizon erkennen, deren Crew als eine der Besten in der Branche galt. Gleiches gilt sicherlich für die Abteilung für IT-Sicherheit bei Facebook. Die Ursache ist das hasardeurhafte Gebaren gewisser Manager, das wiederum ein Resultat fehlender Aufsichtsverantwortung (oder falscher Anreizsysteme) seitens der Unternehmensführung ist.

Mit der Vergleichbarkeit kommt auch die Erkenntnis, warum eine Regulierung so schwer fällt. Es ist keine Frage der Neuartigkeit, vielmehr von Abhängigkeit sowie Machtkonzentration. Unsere Gesellschaft ist abhängig von der Ölförderung (Industriegesellschaft) – gleiches gilt für die sozialen Medien (Informationsgesellschaft). Wir sind aber nicht abhängig von Unternehmen wie Facebook oder BP. Es besteht kein unmittelbarer Zusammenhang zwischen Facebooks Technik und Facebooks Geschäftsmodell.

Unlike industrial businesses, Internet platforms are highly adaptable, and this is the challenge.

Quelle: House of Commons of Canada, Chambre des communes du Canada. (2019, Mai). Standing Committee on Access to Information, Privacy and Ethics: Evidence Roger McNamee (Nr. 152).

Ein Unterschied liegt in der Anpassungsfähigkeit von Big-Data-Unternehmen. Wie wir festgestellt haben, sind die Verwendungszwecke und Endprodukte digitaler Informationen form- und wandelbar. Hieraus entsteht Anpassungsfähigkeit. Dennoch bringt uns die Vergleichbarkeit eine wichtige Erkenntnis. Eine Regulierung der Geschäftsmodelle der Tech-Riesen ist möglich, allerdings trifft auch hier der viel zitierte Satz zu: »Wenn man einen Sumpf trockenlegen will, darf man nicht die Frösche fragen«.

Surveillance capitalism has thrived in the absence of law, as we all know. I take that as a positive sign, because what this means is that we have not failed to rein in this rogue mutation of capitalism. The real issue is that we haven’t really tried. The accompanying good news is that our societies have experience in reining in the raw excesses of a destructive capitalism. […]. We did it in the seventies to save creatures, air, water, workers and consumers. We know how to do this. This is what democracy is for. It is time to do it again.

Quelle: House of Commons of Canada, Chambre des communes du Canada. (2019, Mai). Standing Committee on Access to Information, Privacy and Ethics: Evidence Shoshana Zuboff (Nr. 152).

Eine Voraussetzung für eine wirksame Regulierung ist allerdings die Vermeidung von behördlichen Interessenkonflikten. Im Falle der Deepwater Horizon war der Mineral Management Service (MMS) sowohl für die Lizenzvergabe für die Ausbeutung von Ölfeldern (inkl. Pachteinnahmen) als auch für die Kontrolle von Sicherheit sowie die Einhaltung von Umweltvorschriften zuständig. In Deutschland liegt die Ressortverantwortung für das Bundesdatenschutzgesetz beim Bundesministerium für Wirtschaft (auch das deutsche TTDSG und damit eine Verordnung für Einwilligungsassistenten liegt beim BMWi).

[…] if these companies disappeared tomorrow, the services they offer would not disappear from the marketplace. It would take literally moments. […]. There are substitutes for everything that Google does that are done without surveillance capitalism. Do not in your mind allow any kind of connection between the services you like and the business model of surveillance capitalism. There is no inherent link there, none at all. […]

Quelle: House of Commons of Canada, Chambre des communes du Canada. (2019, Mai). Standing Committee on Access to Information, Privacy and Ethics: Evidence Roger McNamee (Nr. 152).

Der Frage, warum eine Regulierung dringend weiterhin (erste Schritte gibt es bereits) geboten ist, gehen wir in Teil 2 nach. Auch hier werden wir einen Vergleich wagen und uns mit konkreten Beispielen von Desinformation aus dem CA-Skandal beschäftigen.

Bildquellen:

Blowout: Nhor Phai from www.flaticon.com is licensed by CC 3.0 BY

Wenn du über aktuelle Beiträge informiert werden möchtest, hast du verschiedene Möglichkeiten, dem Blog zu folgen:

2 Ergänzungen zu “Facebooks Daten-Blowouts: Eine Verständnisbrücke Teil1”

Wenn du konkrete Fragen hast oder Hilfe benötigst, sind das offizielle Forum oder der Chat geeignete Anlaufstellen, um dein Anliegen zu diskutieren. Per E-Mail beantworte ich grundsätzlich keine (Support-)Anfragen – dazu fehlt mir einfach die Zeit. Kuketz-Forum

Wenn du konkrete Fragen hast oder Hilfe benötigst, sind das offizielle Forum oder der Chat geeignete Anlaufstellen, um dein Anliegen zu diskutieren. Per E-Mail beantworte ich grundsätzlich keine (Support-)Anfragen – dazu fehlt mir einfach die Zeit. Kuketz-ForumAbschließender Hinweis

Blog-Beiträge erheben nicht den Anspruch auf ständige Aktualität und Richtigkeit wie Lexikoneinträge (z.B. Wikipedia), sondern beziehen sich wie Zeitungsartikel auf den Informationsstand zum Zeitpunkt des Redaktionsschlusses.Kritik, Anregungen oder Korrekturvorschläge zu den Beiträgen nehme ich gerne per E-Mail entgegen.

Unterstützen

Unterstützen

Ich glaube, dass Haugen’s Aussagen wichtig sind – aber wichtiger sind die Papiere, die sie veröffentlicht hat. Menschen, die nicht in dem Thema sind, werden sich denken: Frances Haugen wer ist das mir doch egal was die sagt. Da ist es besser darauf zu verweisen was geleakte Papiere von Facebook beweisen.

Wir werden in Teil 2 des Beitrages noch auf die Auswirkungen von Facebooks System zu sprechen kommen. Allerdings möchte ich unterstreichen, dass es das Ziel der Beiträge ist, systemische Probleme von Big Data – Facebook ist lediglich das Standardmodell dafür – darzustellen. Sofern man nun auf die Instagram-Dokumente verweist, betrachtet man nur einen Teil dieses Systems: das engagement based ranking von Inhalten. Gleiches gilt für das Thema Consent – auch ein Teilproblem. Die Diskussion muss immer das ganze Facebook-System in den Blick nehmen. Dieses Prinzip der Betrachtung nennt Shoshana Zuboff: Upstream. Facebooks Geschäftsmodell und System von Datenerhebungen und -übermittlungen sind als Kernproblem zu begreifen.